Deepfake - Deepfake

Deepfakes (en portmanteau av " deep learning " og "fake") er syntetiske medier der en person i et eksisterende bilde eller video er erstattet med andres likhet. Selv om handlingen med forfalskning ikke er ny, utnytter deepfakes kraftige teknikker fra maskinlæring og kunstig intelligens til å manipulere eller generere visuelt og lydinnhold med et stort potensial for å lure. De viktigste maskinlæringsmetodene som brukes for å lage deepfakes er basert på dyp læring og involverer opplæring av generative arkitekturer for nevrale nettverk , for eksempel autoencoders eller generative adversarial networks (GANs).

Deepfakes har fått stor oppmerksomhet for bruk i kjendispornografiske videoer , hevnporno , falske nyheter , hoaxes og økonomisk svindel . Dette har fått svar fra både industri og myndigheter for å oppdage og begrense bruken av dem.

Historie

Fotomanipulasjon ble utviklet på 1800 -tallet og ble snart brukt på film . Teknologien ble stadig bedre i løpet av 1900 -tallet, og raskere med digital video .

Deepfake -teknologi er utviklet av forskere ved akademiske institusjoner som begynte på 1990 -tallet, og senere av amatører i nettsamfunn. Mer nylig har metodene blitt tatt i bruk av industrien.

Akademisk forskning

Akademisk forskning knyttet til deepfakes ligger hovedsakelig innen maskin visjon , et delfelt av informatikk. Et tidlig landemerkeprosjekt var Video Rewrite -programmet, utgitt i 1997, som endret eksisterende videoopptak av en person som snakket for å skildre den personen som munnet ordene i et annet lydspor. Det var det første systemet som fullstendig automatiserte denne typen ansiktsreanimering, og det gjorde det ved å bruke maskinlæringsteknikker for å opprette forbindelser mellom lydene som produseres av en videos emne og formen på motivets ansikt.

Moderne akademiske prosjekter har fokusert på å lage mer realistiske videoer og på å forbedre teknikker. Programmet "Synthesizing Obama", som ble utgitt i 2017, modifiserer videofilmer av tidligere president Barack Obama for å skildre ham i munnen på ordene i et eget lydspor. Prosjektet viser som et hovedforskningsbidrag sin fotorealistiske teknikk for å syntetisere munnformer fra lyd. Face2Face -programmet, utgitt i 2016, endrer videofilmer av en persons ansikt for å skildre dem som etterligner ansiktsuttrykkene til en annen person i sanntid. Prosjektet viser som et hovedforskningsbidrag den første metoden for å gjenopprette ansiktsuttrykk i sanntid ved hjelp av et kamera som ikke fanger dybde, noe som gjør det mulig å utføre teknikken ved hjelp av vanlige forbrukerkameraer.

I august 2018 publiserte forskere ved University of California, Berkeley et papir som introduserte en falsk danse -app som kan skape inntrykk av mesterlig danseevne ved hjelp av AI. Dette prosjektet utvider anvendelsen av deepfakes til hele kroppen; tidligere arbeider fokusert på hodet eller deler av ansiktet.

Forskere har også vist at deepfakes ekspanderer til andre domener som manipulering av medisinske bilder. I dette arbeidet ble det vist hvordan en angriper automatisk kan injisere eller fjerne lungekreft i en pasients 3D CT -skanning. Resultatet var så overbevisende at det lurte tre radiologer og en state-of-the-art lungekreftdeteksjon AI. For å demonstrere trusselen utførte forfatterne med hell angrepet på et sykehus i en penetrasjonstest av hvit hatt .

En undersøkelse av dype forfalskninger, publisert i mai 2020, gir en tidslinje for hvordan oppretting og oppdagelse av dype forfalskninger har utviklet seg de siste årene. Undersøkelsen identifiserer at forskere har fokusert på å løse følgende utfordringer ved oppretting av deepfake:

- Generalisering. Dype forfalskninger av høy kvalitet oppnås ofte ved å trene på timer med opptak av målet. Denne utfordringen er å minimere mengden treningsdata som kreves for å produsere kvalitetsbilder og muliggjøre utførelse av trente modeller på nye identiteter (usett under trening).

- Paret trening. Trening av en modell med tilsyn kan gi resultater av høy kvalitet, men krever dataparring. Dette er prosessen med å finne eksempler på innganger og deres ønskede utganger for modellen å lære av. Dataparring er arbeidskrevende og upraktisk når man trener på flere identiteter og ansiktsatferd. Noen løsninger inkluderer opplæring med egenkontroll (bruk av rammer fra samme video), bruk av uparede nettverk som Cycle-GAN, eller manipulering av nettverksinnbygginger.

- Identitetslekkasje. Det er her identiteten til sjåføren (dvs. skuespilleren som kontrollerer ansiktet i en reenactment) delvis overføres til det genererte ansiktet. Noen foreslåtte løsninger inkluderer oppmerksomhetsmekanismer, få-shot-læring, frakobling, grensekonverteringer og hoppe over tilkoblinger.

- Okklusjoner. Når en del av ansiktet er blokkert med en hånd, hår, briller eller andre gjenstander, kan det oppstå artefakter. En vanlig okklusjon er en lukket munn som skjuler innsiden av munnen og tennene. Noen løsninger inkluderer bildesegmentering under trening og maling.

- Midlertidig sammenheng. I videoer som inneholder deepfakes, kan det oppstå artefakter som flimring og rystelser fordi nettverket ikke har noen sammenheng med de foregående bildene. Noen forskere gir denne konteksten eller bruker nye tap i tidsmessig sammenheng for å forbedre realismen. Etter hvert som teknologien forbedres, blir interferensen avtagende.

Totalt forventes det at deepfakes vil ha flere implikasjoner i medier og samfunn, medieproduksjon, medierepresentasjoner, mediepublikum, kjønn, lov og regulering og politikk.

Amatørutvikling

Begrepet deepfakes stammer fra slutten av 2017 fra en Reddit -bruker som heter "deepfakes". Han, så vel som andre i Reddit -samfunnet r/deepfakes, delte deepfakes de opprettet; mange videoer involverte kjendiseres ansikter byttet til kroppene til skuespillerinner i pornografiske videoer, mens ikke-pornografisk innhold inkluderte mange videoer med skuespilleren Nicolas Cages ansikt byttet til forskjellige filmer.

Andre nettsamfunn gjenstår, inkludert Reddit-fellesskap som ikke deler pornografi, for eksempel r/SFWdeepfakes (forkortelse for "safe for work deepfakes"), der fellesskapsmedlemmer deler deepfakes som skildrer kjendiser, politikere og andre i ikke-pornografiske scenarier. Andre nettsamfunn fortsetter å dele pornografi på plattformer som ikke har forbudt deepfake pornografi.

Kommersiell utvikling

I januar 2018 ble et proprietært skrivebordsprogram kalt FakeApp lansert. Denne appen lar brukerne enkelt lage og dele videoer med ansiktene byttet med hverandre. Fra og med 2019 har FakeApp blitt erstattet av alternativer med åpen kildekode som Faceswap, kommandolinjebasert DeepFaceLab og nettbaserte apper som DeepfakesWeb.com

Større selskaper begynner også å bruke deepfakes. Mobilappgiganten Momo opprettet applikasjonen Zao som lar brukerne legge et ansikt på fjernsyn og filmklipp med et enkelt bilde. Det japanske AI -selskapet DataGrid laget en full body deepfake som kan skape en person fra bunnen av. De har tenkt å bruke disse til mote og klær.

Audio deepfakes og AI -programvare som er i stand til å oppdage deepfakes og klone menneskelige stemmer etter 5 sekunder med lyttetid. En mobil deepfake -app, Impressions, ble lansert i mars 2020. Det var den første appen for å lage kjendis -deepfake -videoer fra mobiltelefoner.

oppstandelse

Deepfakes -teknologi kan ikke bare brukes til å lage meldinger og handlinger fra andre, men den kan også brukes til å gjenopplive avdøde individer. Oktober 2020 la Kim Kardashian ut en video av sin avdøde far Robert Kardashian ; ansiktet i videoen av Robert Kardashian ble laget med deepfake -teknologi. Dette hologrammet ble opprettet av selskapet Kaleida, hvor de bruker en kombinasjon av ytelse, bevegelsessporing, SFX, VFX og DeepFake -teknologier i hologrammen .

Det var også et tilfelle der Joaquin Oliver, offer for Parkland -skytingen, ble gjenoppstått med deepfake -teknologi. Olivers foreldre slo seg sammen på vegne av deres organisasjon Nonprofit Change the Ref, med McCann Health for å produsere denne deepfake-videoen som tar til orde for kampanjen for våpen-sikkerhet. I denne dype falske meldingen viser den Joaquin oppmuntre seerne til å stemme.

Teknikker

Deepfakes er avhengige av en type nevrale nettverk som kalles en autoencoder . Disse består av en koder, som reduserer et bilde til et lavere dimensjonalt latent rom, og en dekoder, som rekonstruerer bildet fra den latente representasjonen. Deepfakes bruker denne arkitekturen ved å ha en universell enkoder som koder en person inn i det latente rommet. Den latente representasjonen inneholder viktige funksjoner om ansiktstrekk og kroppsholdning. Dette kan deretter dekodes med en modell som er opplært spesielt for målet. Dette betyr at målets detaljerte informasjon vil bli lagt over de underliggende ansikts- og kroppsfunksjonene til den originale videoen, representert i det latente rommet.

En populær oppgradering til denne arkitekturen knytter et generativt adversarialt nettverk til dekoderen. Et GAN trener en generator, i dette tilfellet dekoderen, og en diskriminator i et motsatt forhold. Generatoren lager nye bilder fra latent representasjon av kildematerialet, mens diskriminatoren prøver å avgjøre om bildet er generert eller ikke. Dette får generatoren til å lage bilder som etterligner virkeligheten ekstremt godt, ettersom eventuelle feil ville bli fanget opp av diskriminatoren. Begge algoritmene forbedres konstant i et nullsumspill . Dette gjør deepfakes vanskelig å bekjempe ettersom de stadig utvikler seg; hver gang en feil er fastslått, kan den rettes.

applikasjoner

Utpressing

Deepfakes kan brukes til å generere utpressingsmateriell som feilaktig inkriminerer et offer. Siden forfalskningene ikke på en pålitelig måte kan skilles fra ekte materialer, kan ofre for faktisk utpressing nå hevde at de sanne gjenstandene er forfalskninger, noe som gir dem troverdig fornektelse. Effekten er å annullere troverdigheten til eksisterende utpressingsmateriell, noe som sletter lojaliteten til utpressere og ødelegger utpresserens kontroll. Dette fenomenet kan kalles "utpressingsinflasjon", siden det "devaluerer" ekte utpressing, noe som gjør det verdiløst. Det er mulig å gjenbruke maskinvare for gruvedrift med kryptokurrency med et lite program for å generere dette utpressingsinnholdet for et stort antall emner i store mengder, noe som øker tilgangen på falsk utpressingsinnhold ubegrenset og på en svært skalerbar måte.

En rapport fra American Congressional Research Service advarte om at deepfakes kan brukes til å utpresse folkevalgte eller personer med tilgang til klassifisert informasjon for spionasje eller påvirkning .

Pornografi

Mange dype forfalskninger på internett inneholder pornografi av mennesker, ofte kvinnelige kjendiser hvis likhet vanligvis brukes uten deres samtykke. Deepfake -pornografi dukket tydelig opp på Internett i 2017, spesielt på Reddit . En rapport publisert i oktober 2019 av nederlandsk cybersikkerhetsoppstart Deeptrace anslår at 96% av alle dype forfalskninger på nettet var pornografiske. Den første som fanget oppmerksomheten var Daisy Ridley deepfake, som ble omtalt i flere artikler. Andre fremtredende pornografiske dype forfalskninger var av forskjellige andre kjendiser. Fra oktober 2019 var de fleste av de dype forfalskede emnene på internett britiske og amerikanske skuespillerinner. Imidlertid er rundt en fjerdedel av fagene sørkoreansk, hvorav de fleste er K-popstjerner. En annen bekymring er at deepfakes brukes til å produsere barnepornografi (virtuelt seksuelt misbruk av barn).

I juni 2019 ble en nedlastbar Windows- og Linux -applikasjon kalt DeepNude utgitt som brukte nevrale nettverk, spesielt generative motstridende nettverk , for å fjerne klær fra bilder av kvinner. Appen hadde både en betalt og ubetalt versjon, den betalte versjonen kostet $ 50. Juni fjernet skaperne søknaden og refunderte forbrukerne.

Politikk

Deepfakes har blitt brukt til å misrepresentere kjente politikere i videoer.

- I separate videoer har ansiktet til den argentinske presidenten Mauricio Macri blitt erstattet av ansiktet til Adolf Hitler , og Angela Merkels ansikt er blitt erstattet med Donald Trumps ansikt .

- I april 2018 samarbeidet Jordan Peele med Buzzfeed for å lage en dypfake av Barack Obama med Peele -stemmen ; det fungerte som en kunngjøring for offentlig tjeneste for å øke bevisstheten om dype forfalskninger.

- I januar 2019 Fox affiliate KCPQ luftet en deepfake av Trump under sitt ovale kontor adresse , spottet hans utseende og hudfarge (og senere sparket en ansatt funnet ansvarlig for video).

- Under valgkampen i lovgivende forsamling i Delhi i 2020 brukte partiet Delhi Bharatiya Janata lignende teknologi for å distribuere en versjon av en engelskspråklig kampanjereklame av lederen, Manoj Tiwari , oversatt til Haryanvi for å målrette mot Haryana- velgere. En voiceover ble levert av en skuespiller, og AI-trent ved hjelp av video av Tiwari-taler ble brukt til å synkronisere videoen til den nye voiceoveren. En medarbeider i partiet beskrev det som en "positiv" bruk av deepfake -teknologi, som gjorde at de "overbevisende kunne nærme seg målgruppen selv om kandidaten ikke snakket språket til velgerne."

- I april 2020 publiserte den belgiske grenen av Extinction Rebellion en deepfake -video av den belgiske statsministeren Sophie Wilmès på Facebook. Videoen promoterte en mulig kobling mellom avskoging og COVID-19 . Den hadde mer enn 100 000 visninger innen 24 timer og mottok mange kommentarer. På Facebook -siden der videoen dukket opp, tolket mange brukere deepfake -videoen som ekte.

- Bruno Sartori har parodiert politikere som Jair Bolsonaro og Donald Trump .

I juni 2019 holdt USAs husets etterretningskomité høringer om den potensielle ondsinnede bruken av deepfakes for å påvirke valg.

Kunst

I mars 2018 publiserte den tverrfaglige kunstneren Joseph Ayerle videokunstverket Un'emozione per semper 2.0 (engelsk tittel: The Italian Game ). Artisten jobbet med Deepfake -teknologi for å lage en AI -skuespillerinne , en syntetisk versjon av 80 -tallets filmstjerne Ornella Muti , som reiste i tid fra 1978 til 2018. Massachusetts Institute of Technology henviste til dette kunstverket i studien "Creative Wisdom". Kunstneren brukte Ornella Mutis tidsreiser for å utforske generasjonsrefleksjoner, mens han også undersøkte spørsmål om provokasjonens rolle i kunstens verden. For den tekniske erkjennelsen brukte Ayerle scener av fotomodell Kendall Jenner . Programmet erstattet Jenners ansikt med et AI -beregnet ansikt til Ornella Muti. Som et resultat har AI -skuespilleren ansiktet til den italienske skuespilleren Ornella Muti og kroppen til Kendall Jenner.

Skuespiller

Det har vært spekulasjoner om deepfakes som brukes for å lage digitale skuespillere for fremtidige filmer. Digitalt konstruerte/endrede mennesker har allerede blitt brukt i filmer før, og deepfakes kan bidra til ny utvikling i nær fremtid. Deepfake -teknologien har allerede blitt brukt av fans til å sette ansikter inn i eksisterende filmer, for eksempel innsetting av Harrison Fords unge ansikt på Han Solos ansikt i Solo: A Star Wars Story , og teknikker som ligner de som ble brukt av deepfakes ble brukt for skuespill av prinsesse Leia i Rogue One .

Etter hvert som deepfake -teknologien stadig utvikler seg, har Disney forbedret sine visuelle effekter ved å bruke deepfake face swapping -teknologi med høy oppløsning. Disney forbedret teknologien sin gjennom progressiv trening programmert til å identifisere ansiktsuttrykk, implementere en ansiktsbyttingsfunksjon og iterere for å stabilisere og forfine produksjonen. Denne deepfake -teknologien med høy oppløsning vil bli implementert i film- og TV -produksjon - og sparer betydelige drifts- og produksjonskostnader. Disneys modell for deepfake-generasjon kan produsere AI-genererte medier med en oppløsning på 1024 x 1024, som er mye større og gir mer realistiske resultater enn vanlige modeller som produserer medier med en oppløsning på 256 x 256. I tillegg har Disney med denne teknologien muligheten til å gjenopplive døde skuespillere og karakterer med en rask og enkel ansiktsbytte; Disney kan nå gjenopplive og gjenopplive karakterer som fansen kan glede seg over.

Internett meme

I 2020 dukket det opp et internett -meme ved å bruke deepfakes for å generere videoer av mennesker som synger refrenget til "Baka Mitai" (ば か み た い) , en sang fra spillet Yakuza 0 i videospillserien Yakuza . I serien blir den melankolske sangen sunget av spilleren i et karaoke minispill . De fleste iterasjoner av dette meme bruker en video fra 2017 lastet opp av brukeren Dobbsyrules, som synkroniserer sangen på sangen, som en mal.

Sosiale medier

Deepfakes har begynt å se bruk i populære sosiale medieplattformer, særlig gjennom Zao, en kinesisk deepfake -app som lar brukerne erstatte sine egne ansikter på karakterene i scener fra filmer og TV -programmer som Romeo + Juliet og Game of Thrones . Appen ble opprinnelig utsatt for gransking av sine invasive brukerdata og personvernerklæring, hvoretter selskapet la ut en uttalelse som hevdet at den ville revidere retningslinjene. I januar 2020 kunngjorde Facebook at det innførte nye tiltak for å motvirke dette på plattformene.

The Congressional Research Service sitert uspesifisert bevis som viser at utenlandske etterretnings operatives brukes deepfakes å skape sosiale medier kontoer med det formål å rekruttere personer med tilgang til gradert informasjon .

Sockpuppets

Deepfake-fotografier kan brukes til å lage strømper , ikke-eksisterende personer, som er aktive både online og i tradisjonelle medier. Det ser ut til at et dypt falskt fotografi er blitt generert sammen med en legende for en tilsynelatende ikke-eksisterende person ved navn Oliver Taylor, hvis identitet ble beskrevet som en universitetsstudent i Storbritannia. Oliver Taylor -persona sendte inn meningstykker i flere aviser og var aktiv i nettmedier som angrep en britisk juridisk akademiker og hans kone, som "terrorsymfatisører". Akademikeren hadde vakt internasjonal oppmerksomhet i 2018 da han startet et søksmål i Israel mot NSO, et overvåkingsselskap, på vegne av mennesker i Mexico som påsto at de var ofre for NSOs telefonhackingsteknologi . Reuters kunne bare finne knappe poster for Oliver Taylor og "hans" universitet hadde ingen poster for ham. Mange eksperter var enige om at "hans" bilde er en deepfake. Flere aviser har ikke trukket tilbake "hans" artikler eller fjernet dem fra nettstedene sine. Man frykter at slike teknikker er en ny slagmark innen desinformasjon .

Samlinger av dype forfalskede fotografier av ikke-eksisterende mennesker på sosiale nettverk har også blitt distribuert som en del av israelsk partipolitisk propaganda. The Facebook -siden "sionistiske Spring" holdt bilder av ikke-eksisterende personer sammen med sine "vitnesbyrd" påstås å forklare hvorfor de har forlatt sine venstreorienterte politikk for å omfavne den høyreorienterte , og siden også inneholdt store mengder av innlegg fra Prime Israels minister Benjamin Netanyahu og hans sønn og fra andre israelske høyreorienterte kilder. Fotografiene ser ut til å ha blitt generert av " menneskelig bildesyntese " -teknologi, dataprogramvare som tar data fra bilder av virkelige mennesker for å produsere et realistisk sammensatt bilde av en ikke-eksisterende person. I mye av "vitnesbyrdet" var årsaken til å omfavne den politiske høyresiden sjokket ved å få vite om påstått oppfordring til vold mot statsministeren. Høyre-israelske TV-kringkastere sendte deretter "vitnesbyrdet" til denne ikke-eksisterende personen basert på det faktum at de ble "delt" på nettet. Kringkasterne sendte historien, selv om kringkasterne ikke kunne finne slike mennesker, og forklarte "Hvorfor betyr opprinnelsen noe?" Andre Facebook -falske profiler - profiler av fiktive individer - inneholdt materiale som angivelig inneholdt en slik hets mot den høyreorienterte statsministeren, som svar på at statsministeren klaget over at det var et komplott for å drepe ham.

Bekymringer

Bedrageri

Lyddype forfalskninger har blitt brukt som en del av sosialteknisk svindel, og lurt folk til å tro at de mottar instruksjoner fra en pålitelig person. I 2019 ble et britisk energiselskapets administrerende direktør lurt over telefonen da han ble beordret til å overføre € 220 000 til en ungarsk bankkonto av en person som brukte audio deepfake-teknologi for å etterligne stemmen til selskapets administrerende direktør i morselskapet.

Troverdighet og ekthet

Selv om falske bilder lenge har vært mange, har fake film vært vanskeligere, og tilstedeværelsen av deepfakes øker vanskeligheten med å klassifisere videoer som ekte eller ikke. AI -forsker Alex Champandard har sagt at folk bør vite hvor fort ting kan ødelegges med deepfake -teknologi, og at problemet ikke er et teknisk, men snarere et som skal løses ved tillit til informasjon og journalistikk. Deepfakes kan utnyttes til å ærekrenke, etterligne og spre desinformasjon. Den primære fallgruven er at menneskeheten kan falle inn i en tid der det ikke lenger kan fastslås om et medies innhold samsvarer med sannheten.

Tilsvarende uttaler datavitenskapsprofessor Hao Li ved University of Southern California at deepfakes opprettet for ondsinnet bruk, for eksempel falske nyheter, vil være enda mer skadelig hvis ingenting gjøres for å spre bevisstheten om deepfake -teknologi. Li spådde at ekte videoer og dype forfalskninger ville bli umulige å skille i løpet av et halvt år, fra oktober 2019, på grunn av raske fremskritt innen kunstig intelligens og datagrafikk.

Tidligere Google -svindel tsar Shuman Ghosemajumder , har kalt deepfakes som et område av "samfunns bekymring", og sagt at de uunngåelig vil utvikle seg til det punktet hvor de kan genereres automatisk, og en person kan bruke den teknologien til å produsere millioner av deepfake -videoer.

Konsekvensene av en deepfake er ikke signifikante nok til å destabilisere hele regjeringssystemet; Imidlertid har deepfakes muligheten til å skade individuelle enheter enormt. Dette er fordi deepfakes ofte er rettet mot ett individ, og/eller deres forhold til andre i håp om å skape en fortelling som er sterk nok til å påvirke opinionen eller troen. Dette kan gjøres gjennom deepfake voice phishing, som manipulerer lyd for å lage falske telefonsamtaler eller samtaler. En annen metode for dype forfalskninger er fabrikerte private kommentarer, som manipulerer medier for å formidle enkeltpersoner som gir uttrykk for skadelige kommentarer.

I september 2020 offentliggjorde Microsoft at de utvikler et Deepfake -deteksjonsprogramvareverktøy.

Eksempel på hendelser

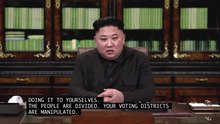

Deepfakes av Nord-Koreas leder Kim Jong-un og Russlands president Vladimir Putin er også opprettet av en upartisk fortalergruppe RepresentUs . Disse dype forfalskningene var ment å bli offentliggjort som reklame for å formidle forestillingen om at innblanding fra disse lederne i amerikanske valg ville være skadelig for USAs demokrati; Reklamen hadde også som mål å sjokkere amerikanerne til å innse hvor skjørt demokrati er, og hvordan medier og nyheter kan påvirke landets vei betydelig uavhengig av troverdighet. Imidlertid inkluderte disse reklamene en sluttkommentar som beskrev at opptakene ikke var ekte, og reklamene til slutt ikke ble sendt på grunn av frykt og følsomhet for hvordan amerikanere kan reagere.

Et klipp fra Nancy Pelosis tale ved Center for American Progress gitt 22. mai 2019 ble bremset, i tillegg til at banen ble endret, for å få det til å virke som om hun var full; kritikere hevder imidlertid at dette ikke er en dyp forfalskning.

Donald Trump dypfalset

En deepfake av Donald Trump ble lett opprettet basert på en skisse Jimmy Fallon fremførte på NBCs The Tonight Show . I denne skiten (sendt 4. mai 2016) kledde Jimmy Fallon seg ut som Donald Trump og lot som om han deltok i en telefonsamtale med Barack Obama, og snakket på en måte som presenterte ham for å skryte av sin primære seier i Indiana. 5. mai 2019 ble en dypfake av Donald Trump (hentet fra denne skitten) opprettet. I denne dype forfalskningen ble ansiktet til Jimmy Fallon forvandlet til Donald Trumps ansikt (lyden forble den samme). Denne deepfake -videoen ble lastet opp til YouTube av grunnleggeren av Derpfakes med en komisk hensikt.

Barack Obama dypfalset

Den amerikanske skuespilleren Jordan Peele , BuzzFeed og Monkeypaw Productions opprettet og produserte en dypfake av Barack Obama (lastet opp til YouTube 17. april 2018) som skildret Barack Obama som forbannet og kalte Donald Trump navn. I denne dype forfalskningen ble Peeles stemme og munn forvandlet og manipulert til Obamas stemme og ansikt. Intensjonen med denne videoen var å skildre de farlige konsekvensene og kraften til deepfakes, og hvordan deepfakes kan få hvem som helst til å si noe.

Positive implikasjoner

Potensielle positive innovasjoner har også dukket opp ved siden av den økende populariteten og skapelsen av deepfakes. For eksempel kan bedriftsopplæringsvideoer opprettes ved hjelp av deepfaked avatarer og deres stemmer. Et eksempel på dette er Synthesia, som bruker deepfake -teknologi med avatarer for å lage personlige videoer.

Svar

Sosiale medieplattformer

Twitter tar aktive tiltak for å håndtere syntetiske og manipulerte medier på plattformen. For å forhindre at desinformasjon sprer seg, legger Twitter et varsel på tweets som inneholder manipulerte medier og/eller dype forfalskninger som signaliserer til seerne at media er manipulert. Det vil også være en advarsel som vises til brukere som planlegger å retweete, like eller engasjere seg i tweeten. Twitter vil også arbeide for å gi brukerne en lenke ved siden av tweeten som inneholder manipulerte eller syntetiske medier som lenker til et Twitter Moment eller troverdig nyhetsartikkel om det relaterte emnet - som en debunking -handling. Twitter har også muligheten til å fjerne tweets som inneholder deepfakes eller manipulerte medier som kan skade brukernes sikkerhet. For bedre å forbedre Twitters oppdagelse av dype forfalskninger og manipulerte medier, har Twitter bedt brukere som er interessante om å samarbeide med dem om å jobbe med deepfake -deteksjonsløsninger for å fylle ut et skjema (som skyldes 27. november 2020).

Facebook har gjort en innsats for å oppmuntre til opprettelse av dype forfalskninger for å utvikle den nyeste programvaren for å oppdage deepfake. Facebook var den fremtredende partneren i verten for Deepfake Detection Challenge (DFDC) , som ble holdt i desember 2019, for 2114 deltakere som genererte mer enn 35000 modeller. De best utøvende modellene med høyest deteksjonsnøyaktighet ble analysert for likheter og forskjeller; disse funnene er områder av interesse for videre forskning for å forbedre og forfine deepfake -deteksjonsmodeller. Facebook har også beskrevet at plattformen vil ta ned medier generert med kunstig intelligens som brukes til å endre en persons tale. Imidlertid vil medier som er blitt redigert for å endre rekkefølgen eller konteksten til ord i budskapet, forbli på siden, men bli merket som falske, siden det ikke ble generert av kunstig intelligens.

Gjenkjenning

Det meste av den akademiske forskningen rundt deepfake søker å oppdage videoene. Den mest populære teknikken er å bruke algoritmer som ligner de som ble brukt til å bygge deepfaken for å oppdage dem. Ved å gjenkjenne mønstre i hvordan deepfakes opprettes, er algoritmen i stand til å fange opp subtile inkonsekvenser. Forskere har utviklet automatiske systemer som undersøker videoer for feil som uregelmessige blinkende mønstre av belysning. Denne teknikken har også blitt kritisert for å ha opprettet et " Moving Goal -innlegg " der algoritmene for å oppdage når som helst blir bedre, det samme gjør deepfakes. Deepfake Detection Challenge, arrangert av en koalisjon av ledende teknologiselskaper, håper å akselerere teknologien for å identifisere manipulert innhold.

Et team ved University of Buffalo publiserte et papir i oktober 2020 som beskrev teknikken deres for å bruke refleksjoner av lys i øynene til de som er avbildet for å oppdage dype forfalskninger med høy suksess, selv uten bruk av et AI -deteksjonsverktøy, i det minste for inntil videre.

Andre teknikker bruker blockchain for å verifisere mediekilden. Videoer må bekreftes via hovedbok før de vises på sosiale medier. Med denne teknologien vil bare videoer fra pålitelige kilder bli godkjent, noe som reduserer spredningen av mulig skadelige deepfake -medier.

Digital signering av alle video- og bilder med kameraer og videokameraer, inkludert smarttelefonkameraer, ble foreslått for å bekjempe deepfakes. Det gjør det mulig å spore hvert fotografi eller video tilbake til den opprinnelige eieren som kan brukes til å forfølge dissidenter.

Internettreaksjon

Siden 2017 har Samantha Cole of Vice publisert en serie artikler som dekker nyheter rundt deepfake -pornografi. 31. januar 2018 begynte Gfycat å fjerne alle deepfakes fra nettstedet. På Reddit ble r/deepfakes subreddit utestengt 7. februar 2018 på grunn av brudd på retningslinjene for "ufrivillig pornografi". I samme måned uttalte representanter fra Twitter at de ville stanse kontoer som mistenkes for å ha lagt ut innhold uten samtykke. Chat -nettstedet Discord har iverksatt tiltak mot deepfakes tidligere, og har tatt en generell holdning mot deepfakes. I september 2018 la Google til "ufrivillige syntetiske pornografiske bilder" på sin forbudsliste, slik at hvem som helst kan be om blokkeringen av resultater som viser falske nakenbilder. I februar 2018 sa Pornhub at det ville forby deepfake -videoer på nettstedet sitt fordi det regnes som " ikke -konsensuelt innhold ”som bryter tjenestevilkårene. De har også tidligere uttalt til Mashable at de vil ta ned innhold som er flagget som deepfakes. Forfattere fra hovedkort fra Buzzfeed News rapporterte at søk etter“ deepfakes ”på Pornhub fortsatt returnerte flere nylige deepfake -videoer.

Facebook har tidligere uttalt at de ikke ville fjerne deepfakes fra plattformene sine. Videoene vil i stedet bli merket som falske av tredjeparter og deretter ha en redusert prioritet i brukerens feeder. Dette svaret ble bedt om i juni 2019 etter at en deepfake med en 2016 -video av Mark Zuckerberg sirkulerte på Facebook og Instagram .

Juridisk respons

I USA har det vært noen reaksjoner på problemene fra deepfakes. I 2018 ble Malicious Deep Fake Prohibition Act introdusert for det amerikanske senatet , og i 2019 ble DEEPFAKES Accountability Act introdusert i Representantenes hus . Flere stater har også innført lovgivning om deepfakes, inkludert Virginia, Texas, California og New York. Oktober 2019 signerte California -guvernør Gavin Newsom lovforsamlingens lovforslag nr. 602 og nr. 730. Forsamlingsforslag nr. 602 gir enkeltpersoner som er målrettet mot seksuelt eksplisitt, dypt forfalsket innhold laget uten deres samtykke, en sak mot sakens opphavsmann. Forsamlingsforslag nr. 730 forbyr distribusjon av ondsinnet deepfake -lyd eller visuelle medier rettet mot en kandidat som stiller til offentlig verv innen 60 dager etter valget.

I november 2019 annonserte Kina at deepfakes og annet syntetisk forfalsket opptakene bør bære et klart varsel om deres fakeness starter i 2020. Manglende overholdelse kan anses som en forbrytelse i Cyberspace Administration of China uttalte på sin hjemmeside. Den kinesiske regjeringen ser ut til å forbeholde seg retten til å straffeforfølge både brukere og online videoplattformer som ikke overholder reglene.

I Storbritannia kan produsenter av deepfake -materiale bli tiltalt for trakassering, men det er krav om å gjøre deepfake til en spesifikk forbrytelse; i USA, hvor anklager så forskjellige som identitetstyveri , cyberstalking og hevnporno har blitt forfulgt, har også forestillingen om en mer omfattende lov blitt diskutert.

I Canada ga Communications Security Establishment ut en rapport som sa at dype forfalskninger kan brukes til å blande seg i kanadisk politikk, særlig for å miskreditere politikere og påvirke velgere. Som et resultat er det flere måter for innbyggere i Canada å håndtere deepfakes hvis de er målrettet av dem.

Svar fra DARPA

Den Defense Advanced Research Projects Agency (DARPA) har finansiert et prosjekt der enkeltpersoner vil konkurrere om å skape AI-genererte videoer, lyd og bilder samt automatiserte verktøy for å oppdage disse deepfakes. DARPA har til og med gjort en innsats for å være vertskap for en "forslagsstillers dag" for et prosjekt tilknyttet Semantic Forensics Program hvor forskere er drevet til å forhindre viral spredning av AI-manipulerte medier. DARPA og Semantic Forensics Program jobber også sammen for å oppdage disse AI-manipulerte mediene gjennom innsats fokusert på å trene datamaskiner for å bruke sunn fornuft, logisk resonnement. DARPA har også opprettet et Media Forensics (MediFor) -program, for å dempe den økende skaden som deepfakes og AI-genererte medier utgjør. Dette programmet tar sikte på ikke bare å oppdage deepfakes, men også gi informasjon om hvordan media ble opprettet. Samtidig er DARPAs mål å ta opp og understreke konsekvensene av deepfakes og deres innflytelse på beslutningstaking.

I populærkulturen

- 1986-utgaven av midten av desember av magasinet Analog publiserte romanen "Picaper" av Jack Wodhams. Handlingen dreier seg om digitalt forbedrede eller digitalt genererte videoer produsert av dyktige hackere som betjener skrupelløse advokater og politiske personer.

- Filmen The Running Man fra 1987 med Arnold Schwarzenegger i hovedrollen skildrer en autokratisk regjering som bruker datamaskiner for å digitalt erstatte ansiktene til skuespillere med de ettersøkte flyktningene for å få det til å se ut som om flyktningene var blitt nøytralisert.

- I teknotrilleren A Philosophical Investigation fra Philip Kerr fra 1992 bruker "Wittgenstein", hovedpersonen og en seriemorder, både en programvare som ligner Deepfake og en virtual reality-drakt for å ha sex med en avatar av den kvinnelige politiløytnanten Isadora "Jake" Jakowicz fikk i oppdrag å fange ham.

- Filmen Rising Sun fra 1993 med Sean Connery og Wesley Snipes i hovedrollen skildrer en annen karakter, Jingo Asakuma, som avslører at en dataplate har endret personlig identitet digitalt for å implisere en konkurrent.

- Deepfake -teknologi er en del av handlingen i BBC One -dramaet The Capture fra 2019 . Serien følger den britiske eks-soldaten Shaun Emery, som er anklaget for overfall og bortføring av advokatfullmektigen. Fagmessig doktorert CCTV -opptak brukes til å sette ham opp og villede politiet som etterforsker ham.

- Al Davis vs. NFL - Den narrative strukturen av 2021 dokumentar, en del av ESPN 's 30 i 30 dokumentarserien, bruk deepfake versjoner av filmens to sentrale karakterer, både deceased- Al Davis , som eide de Las Vegas Raiders under lagets funksjonstid i Oakland og Los Angeles , og Pete Rozelle , NFL -kommisjonæren som ofte kolliderte med Davis.

Se også

- Ansiktsbevegelse

- StyleGAN

- Syntetiske medier

- Virtuell skuespiller

- Identitetserstatningsteknologi

- Hyperreality

Referanser

Eksterne linker

- Sasse, Ben (19. oktober 2018). "Denne nye teknologien kan sende amerikansk politikk til en hale" . Meninger. Washington Post . Hentet 10. juli 2019 .

- Fake/Spoof Audio Detection Challenge (ASVspoof)

- Deepfake Detection Challenge (DFDC)